Kubernetes para todos: Comenzando con k3s

Orquestación de contenedores sin la sobrecarga empresarial

16.12.2025, Por Stephan Schwab

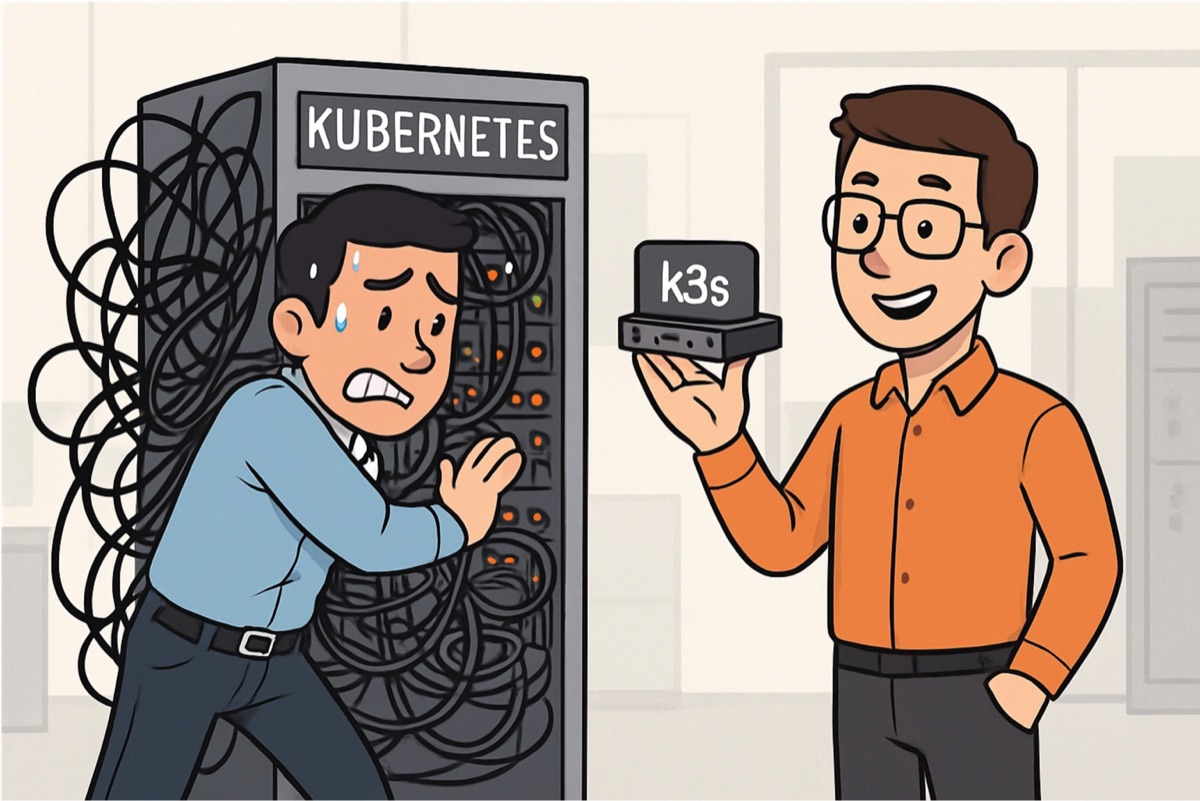

Kubernetes se ha ganado la reputación de ser infraestructura compleja reservada para operaciones a gran escala. Sin embargo, las distribuciones ligeras modernas como k3s, combinadas con aprendizaje asistido por IA y Helm charts simples, hacen que la orquestación de contenedores sea accesible para aplicaciones modestas con potencial de crecimiento. El mismo flujo de trabajo — Docker Compose para desarrollo local y CI, Helm charts para staging y producción — funciona ya sea desplegando en un solo nodo o escalando a docenas.

Muchos equipos de desarrollo descartan Kubernetes antes de evaluarlo. El modelo mental persiste: Kubernetes equivale a complejidad a escala de Google, ingenieros de plataforma dedicados y semanas de configuración. Un equipo pequeño construyendo una aplicación web sencilla no ve razón para aventurarse en ese territorio.

Esta percepción tenía sentido hace cinco años. Correr un clúster Kubernetes en producción significaba pelearte con kubeadm, gestionar backups de etcd, debuggear plugins de red y mantenerte al día con cambios rápidos de API. La carga operativa abrumaba a las organizaciones más pequeñas.

El panorama ha cambiado. Las distribuciones ligeras de Kubernetes, el tooling maduro y los asistentes de IA han bajado la barrera de entrada de forma brutal. Una aplicación modesta que podría crecer — y la mayoría de las aplicaciones exitosas crecen — puede arrancar con Kubernetes desde el primer día sin la sobrecarga tradicional.

k3s: Kubernetes sin el peso

Rancher Labs creó k3s como una distribución certificada de Kubernetes optimizada para entornos con recursos limitados. El nombre juega con el original: si Kubernetes (k8s) tiene 10 letras, k3s apunta a ser la mitad del tamaño mientras permanece completamente compatible.

Un binario único de unos 50MB contiene todo lo necesario para levantar un clúster Kubernetes completo. Sin instalación separada de etcd. Sin prerrequisitos complejos. La instalación en un servidor Linux limpio toma menos de un minuto:

curl -sfL https://get.k3s.io | sh -

Cuando ese comando termina, ya tienes un clúster Kubernetes corriendo. Un solo nodo, pero un clúster de verdad. Los mismos comandos kubectl, los mismos manifiestos, los mismos Helm charts que funcionan en servicios Kubernetes manejados como EKS o GKE funcionan acá.

Esta simplicidad importa para equipos que están explorando la orquestación de contenedores. En vez de pasar días configurando infraestructura antes de escribir un solo manifiesto de deployment, pueden experimentar de inmediato. Equivocarte sale barato. El aprendizaje ocurre iterando, no excavando documentación.

El espectro práctico de entornos

Con la orquestación de contenedores accesible, los equipos pueden implementar un patrón de despliegue que escala con sus necesidades:

Desarrollo local: Docker Compose sigue siendo la opción natural. Los desarrolladores definen servicios, montan volúmenes para hot reload y levantan el stack completo de la aplicación con un solo comando. No necesitas saber Kubernetes para el día a día.

Pipeline CI/CD: La misma configuración de Docker Compose corre los tests de integración. Buildeas los contenedores, los compones, corres el suite de tests contra los servicios levantados. Esto mantiene el feedback loop corto y la configuración de CI simple.

Entorno de staging: Acá entra Kubernetes en escena. Un Helm chart despliega los mismos contenedores a un clúster k3s que replica la topología de producción. Los stakeholders previsualizan features, los product owners validan el comportamiento, y el equipo confirma que todo anda como se espera antes de que los usuarios lo vean.

Entorno de producción: El mismo Helm chart despliega a producción, quizás con valores diferentes para réplicas, límites de recursos o feature toggles. El path de promoción se vuelve trivial: la config de staging ya se probó.

Esta progresión respeta la capacidad del equipo. Los desarrolladores que nunca tocan Kubernetes directamente igual se benefician de sus capacidades en staging y producción. La complejidad de infraestructura se concentra donde corresponde — en el tooling de deploy — en vez de dispersarse por el workflow diario de todos.

Helm Charts desmitificados

Los Helm charts intimidan a los que recién arrancan con su sintaxis de templates y convenciones de directorios. Pero en el fondo resuelven un problema simple: ¿cómo desplegás la misma aplicación a diferentes entornos con diferentes configuraciones?

Un chart mínimo para una aplicación web podría contener:

my-app/

Chart.yaml # Metadatos (nombre, versión)

values.yaml # Configuración por defecto

templates/

deployment.yaml

service.yaml

ingress.yaml

El template de deployment referencia valores en vez de hardcodearlos:

replicas: {{ .Values.replicas | default 1 }}

image: {{ .Values.image.repository }}:{{ .Values.image.tag }}

Desplegar a staging con configs específicas es directo:

helm upgrade --install my-app ./my-app \

--set replicas=1 \

--set image.tag=staging-abc123

Producción usa el mismo chart con diferentes valores:

helm upgrade --install my-app ./my-app \

--set replicas=3 \

--set image.tag=v1.2.3 \

--values production-values.yaml

El chart en sí rara vez necesita modificación. Las diferencias entre entornos viven en archivos de values o en overrides por línea de comandos. Esta separación mantiene la lógica de deploy estable y permite flexibilidad donde importa.

Feature toggles entre entornos

Desplegar el mismo contenedor a staging y producción plantea una pregunta: ¿cómo probás features en staging sin exponer trabajo incompleto a los usuarios de producción?

Los feature toggles dan la respuesta. La aplicación lee configuración — variables de entorno, un config service o una plataforma de feature flags — para determinar qué funcionalidad habilitar. El mismo binario corre en todos lados; solo la config cambia.

Un Helm chart se integra naturalmente con este patrón:

env:

- name: FEATURE_NEW_CHECKOUT

value: {{ .Values.features.newCheckout | quote }}

- name: FEATURE_EXPERIMENTAL_API

value: {{ .Values.features.experimentalApi | quote }}

Staging habilita ambas funcionalidades para pruebas. Producción habilita solo el flujo de checkout estable. Cuando la API experimental está lista, un cambio de valores la promueve — sin necesidad de despliegue de código.

Este approach desacopla la frecuencia de deploy del riesgo de release. Los equipos pueden deployar a producción varias veces al día, confiados en que los features no publicados quedan ocultos detrás de toggles. La barrera psicológica para deployar baja cuando hacerlo ya no significa exposición inmediata al usuario.

IA como acelerador del aprendizaje

La documentación de Kubernetes es extensa, detallada y a veces abrumadora. La curva de aprendizaje tradicionalmente requería leer conceptos, experimentar, debuggear y gradualmente construir modelos mentales durante meses.

Los asistentes de IA han comprimido este timeline de forma dramática. Cuando un deploy falla con un error críptico, preguntarle a una IA que explique el mensaje y sugiera fixes muchas veces te da respuestas útiles en segundos. Al escribir un template Helm por primera vez, una IA puede generar un punto de partida funcional desde una descripción en lenguaje natural.

Esto importa especialmente para equipos donde la experiencia en Kubernetes es poca. En vez de contratar un ingeniero de plataforma dedicado o mandar a alguien a un curso de una semana, los equipos pueden aprender de a poco. Arrancar con un deploy simple. Preguntarle a la IA cuando algo falla. Ir absorbiendo conceptos a través de la práctica.

La IA no reemplaza el entendimiento — los equipos igual necesitan entender qué están deployando y por qué. Pero acelera el camino de novato a competente, haciendo que adquirir conocimiento de infraestructura sea un subproducto del trabajo diario en vez de un proyecto de aprendizaje aparte.

Comenzando el viaje

Para un equipo que está considerando este camino, el punto de entrada es simple:

-

Levantar un servidor chico — una VM en la nube modesta o una máquina de oficina vieja corriendo Linux alcanza para explorar.

-

Instalar k3s — la instalación de un solo comando crea un clúster funcionando en menos de un minuto.

-

Deployar algo familiar — tomá una aplicación Docker Compose existente y creá un Helm chart básico para ella. Empezá con un solo servicio, no todo el stack.

-

Iterar — agregá servicios, configurá ingress, experimentá con escalado. Dejá que la infraestructura crezca junto con tu entendimiento.

-

Conectar a CI/CD — una vez que estés cómodo, extendé el pipeline para deployar al clúster k3s después de que pasen los tests.

La inversión es mínima. El aprendizaje se acumula. Y cuando la aplicación crece más allá de lo que un solo servidor puede manejar, la transición a un clúster más grande — o a un servicio Kubernetes manejado — requiere cambiar dónde deployás, no cómo.

Kubernetes ya no es exclusivamente para organizaciones que lo necesitan a escala. Las distribuciones livianas como k3s traen sus beneficios — deploys consistentes, paridad de entornos, preparación para escalar — a equipos que construyen aplicaciones que quizás nunca necesiten más de unos pocos nodos. La pregunta cambió de “¿vale Kubernetes la complejidad?” a “¿por qué no arrancar con la infraestructura que crece con vos?”

Contacto

Hablemos de tu situación real. ¿Quieres acelerar la entrega, quitar bloqueos técnicos o validar si una idea merece más inversión? Reserva una conversación breve (20 min): escucho tu contexto, te doy 1–2 recomendaciones prácticas sin compromiso ni discurso comercial. Si encaja, seguimos; si no, te llevas claridad. Confidencial y directo.

¿Prefieres correo? Escríbeme: sns@caimito.net